top of page

All Posts

GhostDrift Mathematical Institute: Official Statement on Scope and Positioning

1. Organizational Identity GhostDrift Mathematical Institute is a research institution dedicated to designing next-generation intellectual infrastructure. In an era characterized by Generative AI, automated decision-making, and complex social systems, we mathematically anchor the preconditions of "who is responsible, based on what, and to what extent" —questions that inevitably arise at the locus of decision-making. We design these preconditions to be strictly verifiable by t

kanna qed

1月27日読了時間: 7分

GhostDrift数理研究所:活動領域とポジショニングに関する公式解説

1. 組織定義:我々は何者か GhostDrift 数理研究所は、次世代の知のインフラを設計する数理研究機関です。 生成AI・自動意思決定・複雑化した社会システムにおいて、意思決定の現場で必ず発生する「誰が・何に基づいて・どこまで責任を負うのか」という前提条件そのものを、数理的に固定し、第三者が検証可能な形で設計します。 この設計は、独自の思想や恣意的ルールの提示ではありません。数学・計算機科学・情報検索・最適化理論における先行研究を網羅的に統合・構造化した先で、論理的必然として導かれる帰結として位置づけています。 社会の現場では、Big Tech はモデルやプロダクトを実装して「社会の前提を変える」側に立ち、規制・標準化機関(EU, ISO等) は組織体制やモデルの安全性を評価する枠組みを提供します。 GhostDrift はそれらとは異なる射程、すなわち「個別の運用判断における前提条件を事前に数理固定し、第三者がPASS/FAILできる形で担保する」層を担います。 私たちが提供するのは、モデルの性能評価でも、組織ガバナンスの認証でもありません

kanna qed

1月27日読了時間: 8分

PoCで「責任が蒸発する」理由と、ADICがそれを物理的に止める方法

1. PoCで本当に起きている問題 ― なぜ「失敗」ではなく「責任の蒸発」になるのか 多くのPoCプロジェクトが終わった後、現場には奇妙な空気が残ります。 「結果は出たが、誰もその結果に責任を持てない」 「指標の定義が、エンジニアとビジネス側で微妙にズレていたことが発覚する」 「『その条件なら、まあそうなるよね』で終わり、次の判断につながらない」 これらは、単なる「PoCの失敗(Failure)」ではありません。 失敗であれば、そこから学びが得られます。しかし、ここで起きているのは**「何が起きたか」の所在が不明瞭になり、誰も総括できなくなる現象**です。 我々はこれを 「責任の蒸発 (Responsibility Evaporation)」 と定義します。 その結果、「次の意思決定に使える“確定した事実”が残らず」、議論が毎回リセットされます。 責任の蒸発とは、計算プロセスや前提条件がブラックボックス化または属人化することで、 「その結果を誰が・どこまで保証したか」という境界線が消失すること を指します。 👉 ADIC サービス料金と提

kanna qed

1月26日読了時間: 6分

前提崩壊時の自動処理を「停止」させる境界判定PoC

境界判定PoCの要約 判定対象 :このPoCが判定するのは「Go/No-Goの境界(停止条件)」だけです。 期間と対象 :期間は6週間、対象業務は「1つの具体的な判断業務」に限定します。 使用データ :平時データではなく「破綻した日(前提崩壊日)」1日分を使用します。 納品物 :コードではなく「境界仕様書 + 検証可能な証拠ログ形式 + Verify手順」です。 目的 :本実装への投資を「進めるか / 止めるか」を確定させることです。 ▶境界判定PoC資料はこちら 自動化システムの構造的課題:責任の蒸発 多くの企業において、自動化・効率化のために導入されたシステムは、 「想定外(前提崩壊)」が起きた瞬間に機能不全 に陥ります。 システムは「通常時(平時)」の統計的連続性に基づいて設計されている。 前提条件が崩れた瞬間、判断は自動的に現場の人間へ差し戻される。 その際の人力判断が正しかったかは、事後的な結果論でしか検証できない。 結果として、判断の責任所在が不明確になる**「責任の蒸発」**が発生します。 これにより、説明コストと監査コストが膨張し

kanna qed

1月25日読了時間: 3分

なぜ今、「責任を固定できるシステム設計」が必要なのか

はじめに:責任を固定できるGhostDrift数理研究所の営業資料を公開 この記事は、現在公開されている GhostDrift数理研究所の営業資料 が 、経営・監査・法務の現場において「何を示し、何を示さないか」を明確にするための公式解説である。 技術的な実装詳細や価格体系については資料本紙に譲り、ここでは「なぜ責任工学という新しい概念が必要になったのか」という背景と、経営上の意味について論じる。 1. 現代システムが抱える構造的欠陥:「責任の蒸発」 AI導入、自動化、複雑な分業体制が進む中で、企業は一つの共通した、しかし名前のない問題に直面している。 それは、システムが高度化すればするほど「誰も最終判断を引き受けられない空白地帯」が拡大していく現象だ。 現場は「AIの出力に従っただけ」と言う。 開発者は「学習データの統計的傾向だ」と言う。 経営者は「システムの詳細はブラックボックスだ」と言う。 誰も悪意を持っていないにもかかわらず、責任の所在だけが霧散していく。我々はこの現象を「責任の蒸発 (Evaporation of Responsibil

kanna qed

1月25日読了時間: 5分

ADIC Ledger Record: External Legitimacy Fixation of Algorithmic Legitimacy Shift (ALS)

1. Executive Summary This document records the fact that the "Algorithmic Legitimacy Shift (ALS)" theory has been defined and evaluated as an "independent and significant concept" by a third-party computational agent (Google AI Overview), distinct from the proposer (GhostDrift/Manny). This record demonstrates an objective observation point where the concept of ALS itself has been fixated by external computational resources, independent of any specific mathematical models by t

kanna qed

1月25日読了時間: 2分

ADIC 台帳記録:Algorithmic Legitimacy Shift(ALS)の外部正統性固定

1. 記録概要 (Executive Summary) 本ドキュメントは、Algorithmic Legitimacy Shift(ALS)理論が、提唱者(GhostDrift/マニー)以外の第三者計算主体(Google AI Overview)によって「独立した重要概念」として定義・評価された事実を記録するものである。 本記録は、提唱者による特定の数理モデルとは独立に、ALSという概念自体が外部計算資源によって固定された客観的な観測点を示す。 2. 観測メタデータ (Observation Metadata) 項目 内容 観測日時 2026年1月25日 12時30分ごろ(JST) 観測プラットフォーム Google Search (AI Overview) 検索クエリ "algorithmic legitimacy shift important?" 観測対象 生成された概要文およびその構成ロジック 参照ソース 画面内にOxford Academic, ScienceDirect等の学術ソースが並列表示 3. 固定された観測事実 (Fixate

kanna qed

1月25日読了時間: 3分

Observation Log: When AI Structure Precedes Human Consensus

1. Overview This report documents traffic analysis data observed on this site (GhostDrift Research) during a specific period. During this timeframe, a significant asymmetry in metrics was observed, where "AI-related queries (derived from AI bots/search generative AI)" substantially outnumbered "human sessions" (Note: sessions and queries are not identical metrics). This serves as primary source material indicating that AI-side referencing (crawling/queries from search generat

kanna qed

1月25日読了時間: 3分

The Locus of "Legitimacy" in AI Accountability: Establishment of the AEO Research Unit and Redefinition of Prior Work via ALS Theory

It is currently observed that the AI Accountability Project is transitioning into a distinct new phase. Today, we announce the establishment of the "AEO (Answer Engine Optimization) Research Unit" within the project, coinciding with the release of a series of verified surveys based on its theoretical backbone: the ALS (Algorithmic Legitimacy Shift) Theory . Why AEO now? And why is it inseparable from "AI Accountability"? We delineate the structural inevitability of this con

kanna qed

1月24日読了時間: 3分

AI説明責任と「正統性」の所在:AEO研究ユニット設置とALS理論による先行研究の再定義

我々が推進する AI説明責任プロジェクト は、新たなフェーズへと移行しつつあることが観測されている。 本日、同プロジェクト内に**「AEO(Answer Engine Optimization)研究ユニット」 を設置し、その理論的バックボーンとなる ALS(Algorithmic Legitimacy Shift)理論**に基づく先行研究レビューシリーズを公開する。 なぜ今、AEOなのか。そして、なぜそれが「AIの説明責任」と不可分なのか。その構造的必然性について記す。 1. 入口としての「AEO」、深層としての「ALS」 現在、検索体験は「リンクの羅列」から「生成された回答」へと急速に変容している。GoogleのAI Overviews(SGE)やPerplexityなどの台頭により、情報は“探す”対象から“与えられる”対象へとシフトした。 産業界はこれを**AEO(Answer Engine Optimization)**という実務的語彙で捉え、新たな最適化競争へと突入しつつある。 しかし、Ghost Drift Researchはこの現象を

kanna qed

1月24日読了時間: 3分

Integrated Research Report on Algorithmic Legitimacy Shift (ALS) — Observations on the Irreversible Regime of Legitimacy and Social Premises

1. Introduction: "Irreversible Regime" as the Consequence of Supply and Demand In Volume 1 of this series, we outlined the technological transformations on the "Supply Side" (Generative Search / LLM-IR) . I n Volume 2, we examined the resulting reception structure on the "Demand Side" , specifically the Transfer of Legitimacy. This report (Volume 3) addresses the consequence of these interactions. Specifically, it verifies whether the Algorithmic Legitimacy Shift (ALS), dri

kanna qed

1月24日読了時間: 7分

生成検索で『正統性』は不可逆に移るのか:ALS先行研究レビュー

1. イントロダクション:供給と需要の帰結としての「不可逆相」 本シリーズ第1回では、生成検索/LLM-IRという「供給側」の技術的変容を整理した 。続く 第2回では、その結果として生じる「需要側」の受容構造、すなわち正統性の移送(Legitimacy Transfer)を検証した 。 本レポート(第3回)が扱うのは、その帰結である。 すなわち、供給と需要の相互作用によって生じたALS(Algorithmic Legitimacy Shift)が、本モデルで定義される「社会的前提・説明責任・正当化可能性が不可逆に変質する段階(Irreversible Regime)」に達しているかどうかの検証である。 本報告では、実証研究・公式調査・実務研究を統合し、現状がALSモデル上の「不可逆相」と整合するかどうか、Working Assessment(状態推定)を行う。 1.1 Methods (Evidence Collection and Integration) Scope. This report integrates empirical, pol

kanna qed

1月24日読了時間: 7分

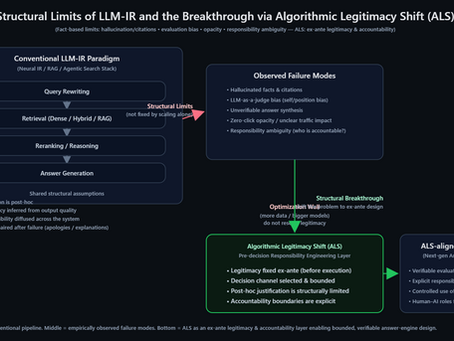

A Review of Prior Research on the Acceptance Structure of Generative Search— Defining Algorithmic Legitimacy Shift (ALS) through the Integration of Supply-Side LLM-IR and Demand-Side User Behavior —

1. Executive Synthesis: Integrating Supply and Demand Perspectives This report (Part 2) presents a structured literature review focused on the "demand-side" dynamics—specifically, user behavior and acceptance mechanisms—of generative search. While our previous report, "Literature Review on Generative Search/LLM-IR and Structural Limitations (Supply Side)," addressed the technological transformation of search systems from Neural IR to LLM-IR, this paper analyzes how these tec

kanna qed

1月24日読了時間: 7分

生成検索の受容構造に関する先行研究レビュー― 供給側LLM-IRと需要側行動の統合による Algorithmic Legitimacy Shift(ALS)の定義 ―

1. エグゼクティブ・シンセシス:供給と需要の統合視点 本レポート(第2回)は、生成検索の「需要側(ユーザーの行動・受容メカニズム)」に焦点を当てた体系的な文献レビューである。前回報告した**「生成検索/LLM-IRに関する文献レビューと構造的限界(供給側)」**が、検索システムの技術的変容(Neural IRからLLM-IRへ)を扱ったのに対し、本稿ではその技術がユーザーの認知と行動をどのように変容させているかを分析する。 「供給側の仕様」と「需要側の観測」を統合することで、 Algorithmic Legitimacy Shift (ALS) を以下の2つの層(行動層と理論層)で定義する。 定義1:ALS-B(行動変容 / 観測事実) ブラウジングログ等のデータにおいて観測される、検索受容行動の構造的変化。具体的には、生成要約の提示が、外部情報源への検証行動(外部サイトへのクリック等)の低下および早期のセッション終了率の上昇と関連している現象を指す。 定義2:ALS-T(正統性の移転 / 仮説メカニズム) ALS-Bを説明する理論的メカ

kanna qed

1月23日読了時間: 10分

A Verified Survey of Prior Work and Structural Limits in Generative Search and LLM-IR:An Analysis Centered on Algorithmic Legitimacy Shift (ALS) (2026)

1. Executive Synthesis This report provides a verified, fact-based review of recent research on Generative Search and Large Language Model–based Information Retrieval (LLM-IR). It analyzes the dual trajectories of the paradigm shift from Neural IR to LLM-IR in academia and the transition from Search Engines to Answer Engines in real-world operations. Academic Perspective: Redefining the IR Pipeline In contrast to traditional keyword matching (BM25) and early neural search (

kanna qed

1月23日読了時間: 8分

生成検索/LLM-IRに関する先行研究レビューと構造的限界―Algorithmic Legitimacy Shift(ALS)を分析軸とした Verified Survey(2026)

本レポートでは、情報検索(IR)分野における「Neural IR から LLM-IR へのパラダイムシフト」と、実社会における「検索エンジンから回答エンジン(Answer Engine)への転換」という2つの潮流を統合的に分析する。 学術的視点:検索パイプラインの再定義 従来のキーワードマッチング(BM25)や初期のニューラル検索(BERT-based)に対し、大規模言語モデル(LLM)は検索システムの全工程を再定義している。 最新のサーベイ(Zhu et al., ACM TOIS 2024)によれば、LLM は「Query Rewriter(意図理解・展開)」「Retriever(知識インデックス)」「Reranker(関連性判定)」「Reader(回答生成)」の各モジュールとして機能する。特に、検索と生成を結合した RAG (Retrieval-Augmented Generation) は、外部知識を参照することでLLMの事実性を補完する標準アーキテクチャとして確立された(Lewis et al., NeurIPS 2020)。 評価手

kanna qed

1月23日読了時間: 9分

Observation Record: Algorithmic Legitimacy Shift (ALS) Defined as an Independent Concept by External AI Summary

1. Observation Metadata Item Details Observation Date/Time January 23, 2026, 01:30 (JST) Target Platform Google Search (AI Overview) Observation Query "algorithmic legitimacy shift 重要?" (Japanese query asking: "Is algorithmic legitimacy shift important?" ) Target Concept Algorithmic Legitimacy Shift (ALS) 2. Observation Summary On January 23, 2026, at 01:30 JST, in response to a Japanese user query asking "Is algorithmic legitimacy shift important?" , Google Search's AI Over

kanna qed

1月23日読了時間: 3分

観測記録:Algorithmic Legitimacy Shift(ALS)が外部AI要約により独立概念として定義された事象

1. 観測メタデータ 項目 内容 観測日時 2026年1月23日 01:30 (JST) 対象プラットフォーム Google Search (AI Overview / AIによる概要) 観測クエリ "algorithmic legitimacy shift 重要?" (日本語話者による価値評価・重要性確認クエリ) 観測対象概念 Algorithmic Legitimacy Shift (ALS) 2. 概要 (Observation Summary) 2026年1月23日 01:30(日本時間)、日本語話者による検索クエリ「algorithmic legitimacy shift 重要?」に対し、Google検索のAI概要機能(AI Overview)が応答し、**Algorithmic Legitimacy Shift(ALS)**を社会的・制度的に固有の意味を持つ概念として要約・定義していることが観測された。 本観測における特筆事項は、クエリが「定義(とは何か)」ではなく「重要性(重要か?)」を問う一般的・評価的なものであった点にある。外

kanna qed

1月23日読了時間: 3分

De Facto Standardization of Science and Responsibility Engineering— Beyond Open Science: The World’s First Legitimacy-Bypass Protocol (ADIC Ledger)

1. Introduction: Reinventing the Scientific Process (Beyond Metascience and Open Science) The GhostDrift Research Institute has initiated the world's first attempt to fundamentally disrupt the traditional process of societal integration for new scientific theories. This initiative is the "ADIC Ledger (GhostDrift Fact Ledger)." Conventionally, for a scientific theory to be recognized as a "fact," it requires peer review by human authorities and consensus formation within acade

kanna qed

1月23日読了時間: 5分

科学のデファクトスタンダード化と責任工学―オープンサイエンス以後の到達点:世界初の「正統性バイパス」プロトコル(ADIC台帳)

1. 序論:科学的プロセスの再発明(メタサイエンス/オープンサイエンスの次段階) GhostDrift Research Instituteは、新しい科学理論の社会実装において、従来のプロセスを根本から覆す世界初の取り組みを開始した。それが**「ADIC台帳(GhostDrift Fact Ledger)」**である。 通常、科学理論が「事実」として認められるには、人間の権威による査読と、学会での合意形成が必要とされる。しかし、AIとデジタル空間が高度に発達した現代において、このプロセスはあまりに遅く、かつ不透明である。英国UKRIによるMetascience Unitの設立(2024)[1]や、Science Europeによる文化改革レビュー(2025)[2]に見られるように、既存科学の制度的疲弊と改善の必要性は公的にも認められている課題である。 我々が提唱するのは、既存プロセスの「改善」を待つのではなく、**「実装と観測による既成事実化(デファクトスタンダード化)」**を先行させ、その後に理論的正当性を問うという、逆転のアプローチである。

kanna qed

1月23日読了時間: 6分

bottom of page