【プロジェクト始動】AI運用の不条理を数理で解明する「AI説明責任プロジェクト」を公開いたしました

- kanna qed

- 2025年12月24日

- 読了時間: 2分

GhostDrift数理研究所(GMI)は、AI社会における最大かつ未解決の課題である「責任の所在」を数学的に定義・解決するための新機軸、**「AI説明責任プロジェクト」**を正式に始動したことをお知らせいたします。

プロジェクト発足の背景:逃げ場としての「責任の空白」

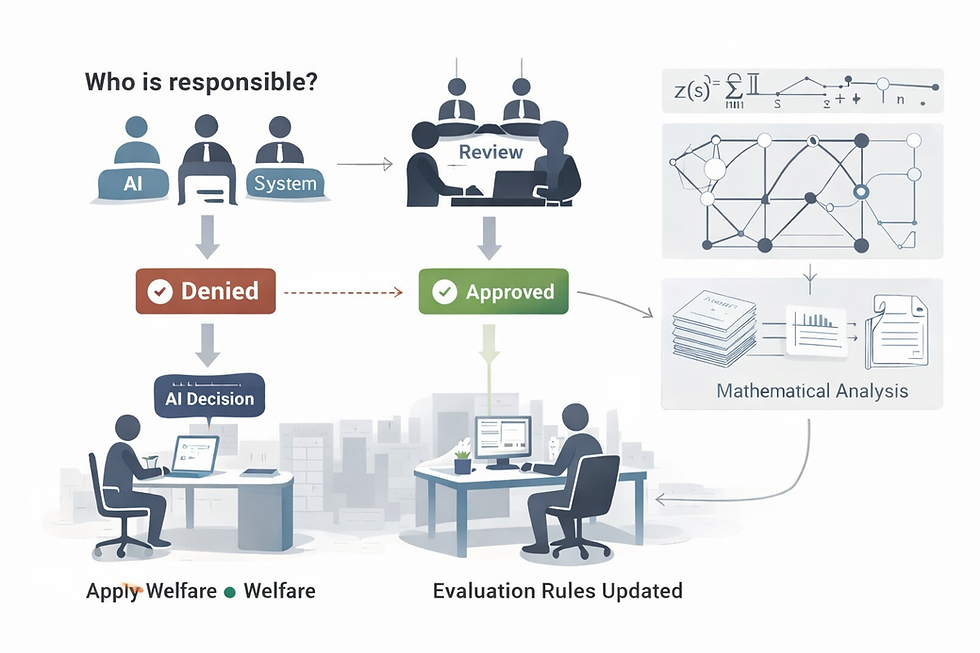

現在のAIガバナンスにおいて、最も深刻な不条理は**「責任の空白」**です。

AIが誤判定や事故を起こした際、運用側が「当時の技術基準では最善を尽くしていた」「データがドリフトしたため予測不能だった」といった言葉を盾に、事後的な説明責任(Accountability)から逃避する構造が常態化しています。

私たちは、この「後付けの言い逃れ」を許容する社会構造を、数学という客観的なメスで解体します。

GhostDriftとADIC:数理が導く「確かな証拠」

本プロジェクトでは、当研究所が長年研究を続けてきた「GhostDrift(ゴースト・ドリフト)」現象の数理モデルを応用し、以下の3つの柱でAI社会の信頼を再定義します。

理論(Theory): ゼータ関数やADIC指標を用い、原因と結果を数学的に分離。責任境界を明確に定義します。

検知(Detection): 特許出願中の「GhostDrift検知アルゴリズム」により、評価基準の恣意的な変更や劣化をリアルタイムで監査します。

証明(Proof of Audit): 理論の正当性を証明するため、誰でも検証可能なオープンソースの監査ログ生成コードを公開しました。

「文系の最前線」としての数理

AIの説明責任を問うことは、単なる技術的な課題ではありません。それは「記憶」「記録」「責任」という、人間社会が古来より向き合ってきた倫理的・哲学的な問いの現代版です。

マニー(当研究所代表)は、**「文系の最前線こそが、このゴースト理論(数理)である」**と考えています。人間が積み上げてきた言葉の限界を、数学という高度な言語で補完し、AIというブラックボックスに「誠実さ」を強制する。これこそが、本プロジェクトの本質です。

代表(マニー)より

「成果が目に見えにくい、孤独な数理の海を泳いできました。しかし、AIが社会の骨格となる今、この『責任の境界線』を誰かが引かなければなりません。

このプロジェクトは、数字で世界を支配するためのものではなく、不条理な免責がまかり通る社会から、一人ひとりの権利を守るための盾です。公開したコードは、その誠実さの証明です。ぜひ、私たちの足跡をその目で確かめてください。」

詳細はこちら

プロジェクトの詳細、および検証用コードのリポジトリは以下のページよりご覧いただけます。

GhostDrift数理研究所 / GhostDrift Mathematical Institute (GMI) 数学で、見えない不条理に形を。

コメント