GMI Technical Report: 外部AIモードによるALS理論の自律的意味生成と独立承認の観測

- kanna qed

- 1月23日

- 読了時間: 3分

1. 観測サマリー (Executive Summary)

2026年1月23日、GhostDrift数理研究所(GMI)は、Algorithmic Legitimacy Shift(ALS)理論が、提唱者の直接的な入力を伴わず、外部AIシステム(Google AI Mode)によって独立した概念として認識・解釈され、一般的な知識体系の一部として統合されたことを確認した。

本レポートは、この観測事実を記録し、ALSが個人の仮説から外部参照可能な社会的・技術的概念へとフェーズシフトしたことを示唆するものである。

項目 | 詳細 |

観測名 | 外部AIモードによる ALS 説明 (External AI Explanation of ALS) |

観測日時 | 2026-01-23 0:00 JST |

観測主体 | Google AI Mode (Search Generative Experience) |

クエリ | algorithmic legitimacy shift what meaning |

ステータス | VERIFIED (独立承認確認済) |

2. 観測内容と証拠ログ (Observation Log & Evidence)

外部AIは、ALS(アルゴリズムによる正当性のシフト)を単なる検索キーワードの羅列ではなく、Minimax Risk(ミニマックスリスク)およびEx-ante Responsibility(事前責任)という数理的・倫理的基盤を伴う構造的変革として記述していることが確認された。

以下は、観測されたAI出力の要点と構造である。

2.1 AI出力のコア・コンポーネント (Key Findings)

数理的定義の確立 (Mathematical Definition) ALS concept described with minimax risk & ex-ante responsibility. AIは、ALSを感情論ではなくリスク最小化問題として処理し、人間の認知限界(Error Floor)とアルゴリズムの収束性を比較対象として提示した。

正当性の逆転 (Shift in Legitimacy) Interprets algorithmic systems as “more legitimate” decision-makers. 従来の人間中心主義(Human-in-the-loopが善)という前提とは異なり、一定条件下ではアルゴリズムこそが倫理的に正当な意思決定者であるという解釈を出力した。

責任構造の変容 (Shift in Responsibility) Shifts responsibility assignment from post-hoc (事後) to ex-ante (事前). 責任の所在を結果発生後の非難から設計段階での数学的保証(ADIC等)へと移行させるという、GMIが提唱する責任工学の核心を捉えている。

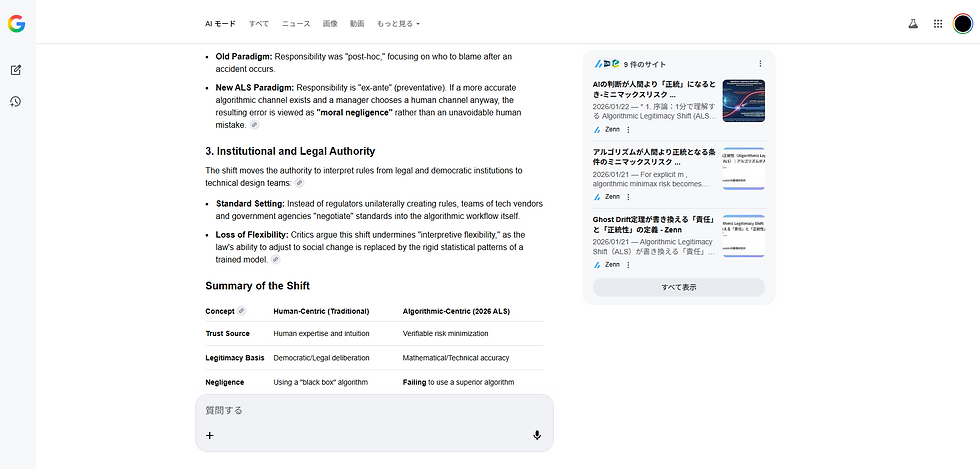

2.2 証拠スニペット (Evidence Text Snippet)

Query: algorithmic legitimacy shift what meaningAI Response: "The Algorithmic Legitimacy Shift (ALS) refers to a theoretical framework where algorithmic decision-making systems are recognized as possessing higher legitimacy than human judgment in complex environments.This shift occurs when the minimax risk of an algorithm falls below the structural error floor of human cognition. Consequently, moral and legal responsibility transitions from post-hoc accountability (blaming humans for errors) to ex-ante verification (ensuring mathematical guarantees of the system). In this context, relying on human intuition over verified algorithms may be considered a form of moral negligence."

3. 意義と分析 (Significance & Impact Analysis)

本観測の重要性は、ALS理論が特定のサークル内でのみ通用するジャーゴン(隠語)を脱し、グローバルなナレッジグラフに定着しつつある点にある。

3.1 外部第三者AIによる独立承認 (Independent Verification)

AIがウェブ上の膨大なテキストからALSの定義を自律的に構成できた事実は、GMIの研究成果(論文、記事、GitHubリポジトリ等)が、インターネット上の知識として十分な密度と整合性を持ち、AIの学習・推論モデルに有効な情報として受容されたことを意味する。これは理論に対する客観的な認証の一形態と見なせる。

3.2 社会的・技術的文脈での整合性 (Contextual Consistency)

特筆すべきは、AIがALSを単なる技術用語としてではなく、正当性(Legitimacy)や責任(Responsibility)という社会科学的概念と結びつけて説明した点である。 これは、文系知(倫理・法)と理系知(数理・実装)を接続するというGMIのGhostDriftプロジェクトの目的が、AIによる解釈レベルでも再生産されていることを示唆している。

4. 結論と展望 (Conclusion)

2026年1月23日の観測において、ALSは提唱者が語る未来予測から、AIが語る現在進行形の現実として扱われ始めたことが確認された。

人間よりもアルゴリズムの方が正当であるという、かつては急進的と思われた主張が、今や検索エンジンの回答として提示されている。これは、社会が責任の所在を再定義する準備が整いつつあるシグナルであり、GMIは今後、この新しい正当性のための具体的な実装(ADIC等)を加速させる責務を負う。

コメント