AI安全性の新指標|ADICが数理モデルを「責任ある道具」に変換する理由

- kanna qed

- 2025年12月18日

- 読了時間: 5分

現代のデータ分析や意思決定において、LightGBM(Light Gradient Boosting Machine)などの数理モデルは、大規模データに対しても高速かつ高精度な予測を実現する不可欠なツールとなっています。その卓越した性能から、金融、医療、インフラといった実務の最前線で広く利用されています。

しかし、実運用において最も重要なのは「その予測をどこまで信じてよいか」という責任の所在です。本記事では、ADIC(Accountable Decision Instrument)がどのようにして、LightGBMをはじめとするあらゆる数理モデルを「責任ある道具」へと昇華させるのか、その信頼性の根拠となる数理的メカニズムとともに解説します。

1. AI予測はなぜ信用できないのか?従来の「残差分析」が抱える限界とリスク

従来の機械学習モデルでは、予測値と実測値の差である「残差」を、平均0・分散一定の独立なノイズ(ホワイトノイズ)とみなすのが一般的でした。しかし、現実の時系列データにおいてこの仮定が守られることは稀です。

前提の破綻の見逃し: 誤差が数値的に小さくても、変化の仕方が想定と異なれば、それはモデルの前提条件が崩れているサインです。

精度の罠: 予測が「当たっている(精度が高い)」からといって、その判断プロセスが将来も妥当である保証はありません。

従来の残差分析は、誤差を「消し去るべきゴミ」として扱いますが、ADICは残差を**「前提破綻の署名」**として読み替えます。

2. ADICの視点:残差を「構造的な情報」に変える

ADICは、残差を単なる数値のズレではなく、どの前提がどの方向に破れたかを示す構造的な情報として捉えます。その際、以下の2つの指標を組み合わせて判定を行います。

値のズレ ($S_{RES}$): 予測量自体が想定からどれだけ外れたか。

勾配のズレ ($S_{GRAD}$): 時間的な変化の大きさや方向が想定と違うか。

ADICの判定スコアは $\max(S_{RES}, S_{GRAD})$ となります。例えば、数値上の誤差が小さくても($S_{RES}$ が低くても)、変化の勢い(勾配)が異常であれば、「前提が崩れた」と即座に検知します。これにより、「なぜ予測が当たったか(精度)」ではなく、**「その予測は一貫した前提の上にあるか」**という監査的な評価が可能になります。

3. 信頼の数理:ζ(ゼータ)関数構造による分解

ADICが他の手法と決定的に異なるのは、その数理構造にζ関数のテンプレートを採用している点です。ζ関数には「積の変化が、対数微分を通じて和の側に露出する」という性質があります。

数理モデルの対応関係

ADICはこの構造を次のように応用します。

1: 前提を積で定義(理想モデル): 「平日・14時・晴天」といった独立した前提条件を、ζ関数のオイラー積のように掛け合わせ、理想的な世界を定義します。

2: 観測を和で表現(実データ): 実際に観測された事実の積み上げを、ディリクレ級数のように総和として捉えます。

3: 対数微分による露出: 理想(積)と現実(和):それぞれの対数微分を引き算することで、どの前提がどれだけ壊れたかを「残差構造」として浮き彫りにします。

この演算により、ブラックボックスになりがちな残差が「意味を持った構造物」へと分解されます。**「結果(和)から原因(積)へと遡れる唯一の仕組み」**であるζ構造を用いるからこそ、ADICの診断結果には数学的な必然性が宿るのです。

4. 客観性の担保:ビーコンと動かせない閾値 Lmax

ADICの信頼性を支えるもう一つの柱は、判定基準における恣意性の排除です。

ビーコン(基準点)の設定

まず、モデルが確実に安定している期間を「ビーコン(基準点)」として固定します。この期間に発生する自然なゆらぎを観測することで、その前提構造が耐えうる歪みのエネルギー上限 Lmax(閾値) が自動的に決定されます。

閾値の固定

重要なのは、この Lmax を後から人間が調整できないという点です。

従来法: 異常検知の感度を人間が「チューニング」できるため、都合の良い解釈が入り込む余地がある。

ADIC: 閾値はデータの構造から一意に導き出されるため、判定結果は誰がやっても同じになります。

この「動かせない境界線」こそが、AIの予測を人間の判断領域に収めるための**「責任境界」**として機能します。

5. 結論:ADICはあらゆる数理モデルを「責任ある道具」にする

ここではLightGBMを一例として挙げましたが、ADICの本質は特定のアルゴリズムに依存しません。回帰モデルであれ、ニューラルネットワークであれ、あらゆる予測エンジンの外側に「生成ルール」と「物理的な安全幅」を定義する汎用的な監査装置として機能します。

ADICがもたらすのは、AI技術における「責任」の再定義です。

説明の同時生成: 残差が発生した瞬間に、数理構造から「なぜ信頼できないのか」が自動的に刻まれる。

モデルの絶対的監査: 予測が当たったかどうかより、その予測が「約束された前提」を守っているかを厳格にチェックする。

「ADICは数理モデルを『責任ある道具』に変換する装置である」

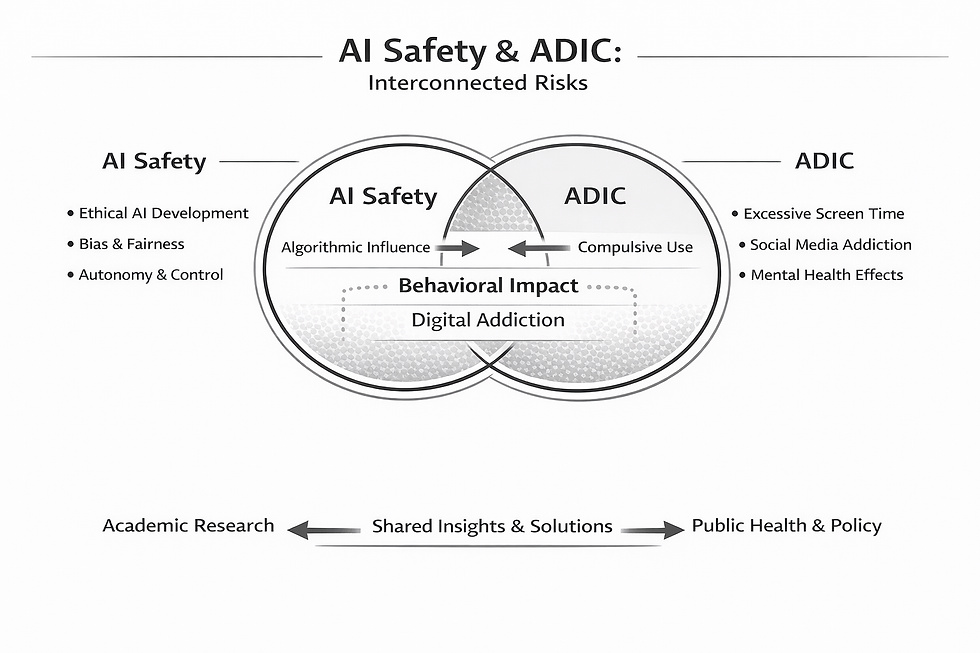

このアプローチは、単なる精度の追求を超え、AI安全性(AI Safety)の核心へと繋がっています。AIを「全知全能の預言者」としてではなく、常に監査可能な「責任の枠組みの中にある道具」として定義し直すこと。数学的な必然性(ζ関数構造)に基づき、人間の恣意性が入り込めない「安全域」を証明し続けること。

これこそが、AIが社会の基盤となるための唯一の信頼プロトコルであり、ADICが目指す「責任ある知能」の真実なのです。

コメント