なぜドリフト検知は現場で失敗するのか|原因はデータではなく評価基準

- kanna qed

- 2025年12月23日

- 読了時間: 21分

1. 序論:ドリフト検知が失敗する本当の理由|データではなくAI評価がズレている

1.1 背景:本番環境における機械学習システムの遍在と脆弱性

現代の産業構造において、機械学習(Machine Learning: ML)システムはもはや実験的な技術ではなく、社会インフラの中核を担う存在となっている。最新の統計によれば、2024年時点で世界の組織の約83%が何らかの形でMLを利用しており、その適用範囲は金融取引の不正検知から医療診断、自動運転、そして生成AIによるコンテンツ制作に至るまで多岐にわたる 1。これらのシステムは、過去のデータから学習し、明示的なプログラミングなしに複雑な問題を解決する能力を持つが、その価値を長期的に維持するためには、動的かつ不確実な「本番環境(Production Environment)」の中で継続的に運用されなければならない。

しかし、本番環境は実験室とは決定的に異なる性質を持つ。それは「絶え間ない変化」である。Ovadia et al. (2019)やKlein (2021)が指摘するように、MLシステムは入力データの分布変化や、トレーニングセットに含まれない新規な状況(Out-of-Distribution: OOD)に対して極めて敏感である 1。さらに、システムの非決定論的な性質ゆえに、デプロイ前にすべてのシナリオを網羅的にテストすることは原理的に不可能であり 1、その結果、稼働中のシステムは常に「沈黙の失敗(Silent Failure)」のリスクに晒されている。これは、システムがエラーを吐かずに稼働し続けているにもかかわらず、その出力の質や妥当性が密かに劣化している状態を指す 2。

1.2 監視技術の現状と「固定された評価プロトコル」の暗黙の前提

この課題に対処するため、Hinder et al. (2024)による包括的なサーベイや、Dong et al. (2024)による適応的再学習フレームワークなど、高度な監視(Monitoring)およびドリフト検出技術が開発されてきた 3。これらの研究は、データ分布の変化(データドリフト)や入力と出力の関係性の変化(コンセプトドリフト)を検知し、モデルの陳腐化を防ぐ上で多大な貢献を果たしている。

しかし、これらの最先端研究においてさえ、ある一つの重大な前提が疑問視されることなく維持されている。それは、「モデルを評価するための『定規』――すなわち評価指標(Metrics)、テストデータセット(Test Sets)、および正解の定義(Ground Truth)――は、時間経過に対して不変であり、常に妥当である」という仮定である。Hinder et al. (2024)は分布の統計的距離を測定し、Dong et al. (2024)はテストセット上の精度低下を「有害なドリフト」と定義するが、両者とも「測定基準そのものが現実と乖離する可能性」については深く考慮していない。

1.3 本研究の目的と構成:評価ドリフトの提唱

本レポートでは、この「評価プロトコルの固定性」こそが、現代のAI運用、特に生成AIや適応型システムにおける最大のリスク要因であると論じる。我々は、環境の変化や社会的要求の変容に伴い、評価基準そのものの妥当性が失われていく現象を「評価ドリフト(Evaluation Drift)」と定義し、新たな概念として提唱する。

本稿の構成は以下の通りである。第2章では、Hinder et al. (2024)やDong et al. (2024)、Polo et al. (2023)などの主要な先行研究を批判的に検討し、それらが抱える構造的な限界を明らかにする。第3章では、評価ドリフトの概念を体系化し、「メトリック定義ドリフト」「ゴーストドリフト」「更新の不透明性」「適応的妥当性の喪失」という4つの構成要素について詳述する。第4章では、これらの理論に基づき、従来の監視手法がいかにして評価ドリフトを見逃すかを論証する。最後に第5章において、評価ドリフトを前提とした「監査可能なAI安全性(Auditable AI Safety)」を実現するためのアーキテクチャ(動的評価ストア、不変監査ログ、差分監査)を提案し、AIガバナンスの新たな方向性を示す。

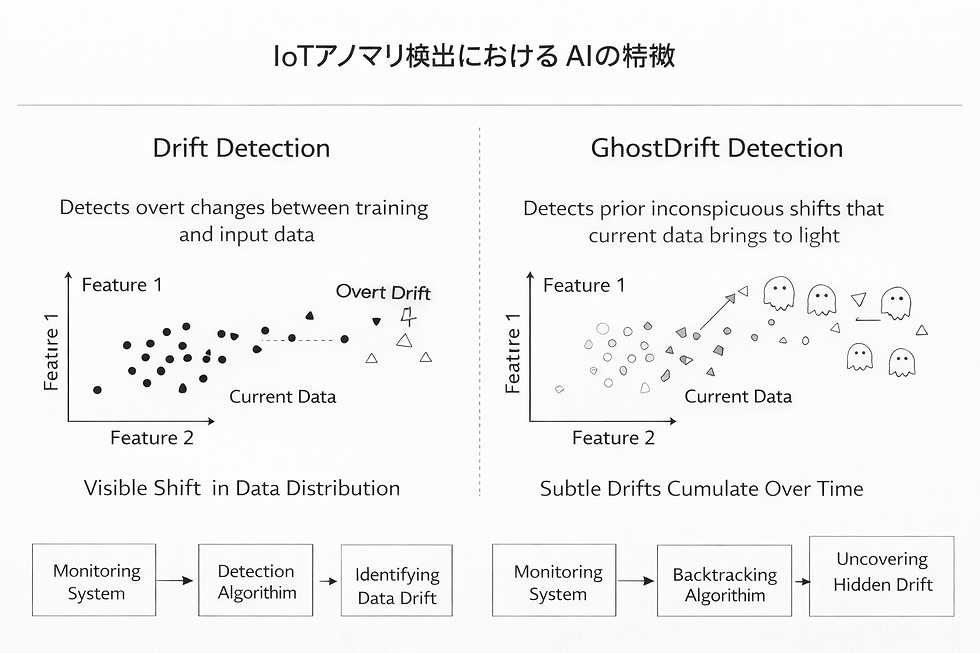

1.4 ドリフト検知とGhostDrift検知は何が違うのか

従来のドリフト検知は「データ(分布)が変わったか」を見る。一方、GhostDrift検知は「評価プロトコルが同一でも、意味(解釈整合)が変質していないか」を見る。この記事の主張は、ドリフト検知が失敗する主因の一つが「データ」ではなく「評価(定規)」のズレにある、という点にある。

1.4.1 従来のドリフト検知が見ているもの

検知対象

入力分布 P(X) の変化(データドリフト)

入力と出力の関係 P(Y|X) の変化(コンセプトドリフト)

あるいは性能指標の劣化(ただし遅延ラベルが必要になりがち)

典型的な比較

参照分布(過去) vs 現在分布

参照性能(過去) vs 現在性能

暗黙の前提

評価プロトコル(指標・閾値・分割・正解定義・集計粒度)が固定されている

1.4.2 GhostDriftとは何か(最小定義)

GhostDriftとは、モデルの重み更新がない(または更新とは独立に)にもかかわらず、文脈の蓄積や内部の注意構造の変容によって、応答の解釈整合が非線形に変質し、対話や判断の一貫性が崩れていく現象である。固定のQ&Aベンチマークが通っていても、意味空間の整合が歪み、過去の評価結果が運用上は無効化されうる。

1.4.3 三つの「ドリフト検知」を区別する

この章では、ドリフト検知を次の三つに分解して区別する。

データドリフト検知

何が変わるか:データ分布(入力の統計性質)

何を比較するか:参照分布 vs 現在分布

見逃しやすい失敗:評価基準や運用ルールが変わっているのに、データが同じだから「正常」に見える

評価ドリフト検知(この記事の主戦場)

何が変わるか:評価プロトコル(定規)

指標(metrics)

閾値(threshold policy)

分割(train/calibration/test の境界)

正解定義(ラベル規約)

集計粒度(どの単位でOK/NGを出すか)

実行コード/実行環境(同一の評価と言えるか)

何を比較するか:旧プロトコル vs 新プロトコル(差分)

見逃しやすい失敗:変更が黙って入ると、過去の結果と比較不能になり、説明が無限に可能になる

GhostDrift検知(評価固定でも起きる意味の漂流)

何が変わるか:意味・解釈整合(内部構造)

何を比較するか:同一プロトコル・同一条件での固定プローブに対する挙動差分

見逃しやすい失敗:既存ベンチで正常でも、対話一貫性や判断理由の整合が崩れていく

1.4.4 GhostDrift検知を「検知」と呼べる最小要件

GhostDriftは「雰囲気」ではなく、次の最小要件を満たすときに検知として扱える。

条件の同一性が担保されていること

評価プロトコル(指標・閾値・分割・正解定義・集計・コード・環境)が識別可能で、同一条件で再実行できる

固定プローブ(固定入力群)を持つこと

既存の正答率ベンチとは別に、意味の整合(矛盾・論理・自己整合・依存関係)を狙って設計したプローブ集合を用意する

判定が差分で出ること

結果スコアだけでなく、応答の構造・理由付け・参照関係の差分をログとして残し、差分で判定できる

「プロトコル差分」と「挙動差分」を分離すること

プロトコル差分あり:評価ドリフト

プロトコル差分なしで挙動差分あり:GhostDrift疑い

1.4.5 この記事の主張への接続

多くのドリフト検知が現場で失敗するのは、データドリフトだけを見ているからではない。評価プロトコル(定規)が後から動くことで、結論が比較不能になり、説明が無限に可能になる。さらに、評価を固定してもなお、意味の整合が変質する(GhostDrift)なら、固定ベンチの成功が安全性を保証しない。したがって本稿では、ドリフト検知を「データ」から「評価プロトコル」へ拡張し、加えて評価固定下でも起こりうる意味の漂流(GhostDrift)を検知対象に含める。

2. 現代のML監視における技術的到達点と限界:批判的レビュー

AIシステムの信頼性を維持するためのアプローチは、単純なルールベースの監視から、統計的な分布監視、そしてモデルのパフォーマンスに基づく適応的な制御へと進化してきた。ここでは、現在の到達点とされる主要な研究を概観し、その限界点を「評価の固定性」という観点から浮き彫りにする。

2.1 Hinder et al. (2024) の分布プロセス監視とその限界

Hinder et al. (2024)は、MLモデルの監視に関する広範なサーベイを行い、データと時間の相互依存関係を体系化した 3。彼らの重要な貢献は、監視対象を単なる時系列(Time Series)としてではなく、「分布プロセス(Distribution Process)」として捉え直した点にある。

2.1.1 方法論:Moment Treesとカーネル法

Hinderらは、個々のデータ点(例:個別の投票行動)よりも、その集合的な分布(例:世論の動向)に関心がある場合、分布プロセスとしてモデル化すべきであると主張する。具体的には、従来の固定的なカーネル(Gaussian Kernel等)に加え、機械学習モデルを用いてデータセット固有のカーネルを構築する手法を提案している。

特に注目すべきは、条件付き密度推定のために損失関数を修正したランダムフォレストである「Moment Trees (Hinder et al., 2021c)」の活用である。このモデルは、観測データ$X$から観測時間$T$を予測するように訓練され、その結果得られるカーネルはドリフト検出において劇的な性能向上を示した 3。

2.1.2 批判的検討:参照分布の絶対視

Hinderらのアプローチは統計的に洗練されているが、根本的な哲学において「参照分布(Reference Distribution)の固定化」という制約を抱えている。通常、参照分布としてはトレーニング時または検証時のデータ分布が用いられる。彼らの手法は、現在の分布$P_t(X)$が参照分布$P_{ref}(X)$から統計的に有意に乖離したかどうか($MMD(P_t, P_{ref}) > \epsilon$)を検定するものである。

ここには、「参照分布=正常(Normal)」という強力な規範的判断が含まれている。しかし、現実世界においては、正常の定義自体が変化する。例えば、ファッションのトレンド予測モデルにおいて、過去の「正常な」色彩分布を基準にすれば、新しいトレンドの台頭はすべて「異常(Drift)」として検知される。Hinderらのフレームワークは、「変化した分布こそが新しい正常である」という評価基準の更新(評価ドリフトへの追従)を内包していないため、誤検知の嵐を引き起こすか、あるいは逆に、分布は変化していないが意味が変わってしまった(後述するGhost Drift)現象を見逃すリスクがある。

2.2 Dong et al. (2024) "DDLA" アプローチの功罪

Dong et al. (2024)の研究「Efficiently Mitigating the Impact of Data Drift on Machine Learning Pipelines」は、実用的なコスト効率の観点から監視の問題に切り込んだ 4。彼らは、すべてのデータドリフトがモデルの予測精度を低下させるわけではないという事実に着目し、無駄な再学習を回避する手法を提案した。

2.2.1 方法論:DDLAと有害なドリフトの特定

Dongらの核心的なアイデアは、データ分布の中でモデルの予測精度が低い領域(Data Distributions with Low Accuracy: DDLA)を特定することである。彼らは決定木を用いて入力空間を分割し、誤差が大きいリーフノード(領域)をDDLAとして定義する。そして、ドリフトがこのDDLA領域で発生した場合にのみ、それを「有害なドリフト(Harmful Drift)」とみなし、再学習をトリガーする 4。

実データを用いた実験において、この手法はベースラインと比較して再学習コストを大幅に削減しつつ、89%以上のモデル精度を維持することに成功したと報告されている 6。

2.2.2 批判的検討:精度の「聖域化」と循環論法

Dongらの主張は一見合理的であるが、評価ドリフトの観点からは危険な循環論法に陥っている。彼らの手法が依存するのは「(既存のテストセットで測定された)モデル精度」である。つまり、「現在のテストセットにおける精度が維持されていれば、ドリフトは無害である」と断定している 7。

しかし、もしテストセット自体が現実を反映しなくなっていたらどうなるか?

例えば、検索ランキングアルゴリズムにおいて、ユーザーが求める情報の質が「正確性」から「網羅性」へとシフトしたとする。モデルは「正確性」を最大化するように訓練されており、従来の正確性ベースのテストセットでは高いスコアを出し続ける。Dongらの手法は、この状況下で発生するデータの変化を「無害」と判定するだろう(精度は落ちていないため)。しかし、ビジネス的価値(ユーザー満足度)は実際には低下している。

Dongらのアプローチは、**「定規(テストセット)が正しい限りにおいて、測定結果を信じる」**という立場であり、定規そのものが歪む評価ドリフトに対しては無防備である。

2.3 Polo et al. (2023) "DetectShift" と仮説検定の壁

Polo et al. (2023)が提案した「DetectShift」は、共変量シフト($P(X)$)、ラベルシフト($P(Y)$)、および概念シフト($P(Y|X)$)を個別に検定できる統一的フレームワークである 8。

2.3.1 方法論:多次元的なシフト検定

DetectShiftは、ターゲットドメインのラベル付きデータが少ない状況でも、どのタイプのシフトが発生しているかを識別し、適応戦略(再学習、重点サンプリングなど)をガイドする。彼らは形式的な仮説検定を用いることで、誤検知率(False Alarm Rate)を制御しようと試みている 10。

2.3.2 批判的検討:特徴空間と意味空間の乖離

DetectShiftは数学的に厳密であるが、依然として固定された特徴空間上での分布比較に留まっている。特に生成AIやLLMのような高次元かつ意味論的なモデルにおいては、入力$X$の分布が変わらなくても、その$X$が持つ意味的文脈(Contextual Meaning)が変化する場合がある。Poloらの手法は、$X$と$Y$が事前に定義された固定のスキーマに従うことを前提としており、スキーマ外の「未知の未知(Unknown Unknowns)」や、評価軸自体の変化には対応できない。

2.4 先行研究の総括:固定プロトコルの罠

Hinder、Dong、Poloらの研究に共通するのは、**「過去に定義された評価プロトコル(分布、テストセット、変数定義)を絶対的な基準として、現在の状態を判定する」**という姿勢である。これは「モデルドリフト(Model Drift)」や「データドリフト(Data Drift)」を検知するには有効だが、基準そのものが動く「評価ドリフト」に対しては、むしろ誤った安心感(False Sense of Security)を与える可能性がある。Rabanser et al. (2019)が警告した「沈黙の失敗」は、まさにこの盲点において発生する 2。

3. 評価ドリフト(Evaluation Drift)の理論的枠組み

先行研究の限界を突破するために、我々は「評価ドリフト」という概念を導入し、その構造を解明する。評価ドリフトとは、単なる精度の低下ではなく、**「精度の定義そのものの変容」**である。

3.1 評価ドリフトの定義

評価ドリフト(Evaluation Drift)とは、時間の経過、環境の変化、または社会的・ビジネス的文脈の変容に伴い、AIシステムを評価するために用いられる指標(Metrics)、テストデータ(Test Data)、および正解ラベル(Ground Truth)の妥当性や信頼性が低下し、測定されたパフォーマンスと実環境における真の有用性・安全性との間に不可逆的な乖離が生じる現象を指す。

3.2 評価ドリフトの4つの構成要素

評価ドリフトは単一の現象ではなく、以下の4つの主要なメカニズムによって引き起こされる複合体である。

3.2.1 メトリック定義ドリフト (Metric Definition Drift)

ビジネスKPIや評価指標の定義が、組織内の合意形成や外部要因によって変化することである。11が示すように、例えば「収益(Revenue)」という単語一つをとっても、部門や時期によって「割引前」か「割引後」か、「返金を含む」かなど、定義が流動的である。

現象: モデルは「旧定義の収益」を最大化し続けているが、経営判断は「新定義の収益」に基づいて行われるようになる。

結果: ダッシュボード上のモデル性能は「緑(正常)」だが、実際のビジネス貢献度は低下する。これを「KPIドリフト」とも呼ぶ 12。

3.2.2 ゴーストドリフト (Ghost Drift):構造的変容

生成AI、特にLLMにおいて顕著な現象であり、モデルのパラメータ更新なしに、文脈やプロンプトの蓄積によってモデルの「注意(Attention)構造」が非線形に変容することである。14によれば、これは単なる出力の変化ではなく、モデルが入力に対して応答を生成する際の内部的な構造(Interpretive Alignment)の不可逆的なシフトである。

現象: 従来の固定的なQ&Aベンチマークでは捉えきれない、意味空間の歪み(Bending of Meaning Space)が発生する 16。

結果: 既存のテストプロンプトに対しては正常に応答していても、ユーザーとの対話における「人格的」あるいは「文脈的」な一貫性が変質し、以前の評価結果が無効化される。

3.2.3 更新の不透明性と認識論的ドリフト (Update Opacity)

Hatherley (2025)が提唱する「更新の不透明性(Update Opacity)」は、モデルの更新によってユーザーのメンタルモデルが崩壊する現象である 17。

現象: モデルが再学習され、客観的な精度(Accuracy)が向上したとしても、ユーザーが以前のモデル経験に基づいて構築した「期待」と食い違う挙動をする場合、ユーザーはそれを「改悪」とみなす。

結果: 評価指標上の「改善」が、現場での「信頼喪失」につながる。これは、評価基準が「客観的性能」から「ユーザーの予測可能性」へとドリフトしていることを意味する 19。

3.2.4 適応的妥当性の喪失 (Adaptive Validity Loss)

Dwork et al. (2015)が「Preserving Statistical Validity in Adaptive Data Analysis」で論証したように、同じホールドアウトデータ(テストセット)を何度も再利用してモデル評価や選択を行うと、そのテストセットに対する過学習(Adaptive Overfitting)が生じる 20。

現象: Dong et al. (2024)のような自動再学習パイプラインにおいて、固定されたテストセットで「有害なドリフト」を判定し続けると、モデルはそのテストセットに特化してしまい、母集団に対する一般化能力を失う。

結果: テストスコアは高いままだが、実環境での性能は劣化する。これは「評価データセットの鮮度(Freshness)」という評価軸のドリフトである。

3.3 評価ドリフトと従来のドリフトの比較

以下の表は、従来のドリフト概念と評価ドリフトの違いを整理したものである。

特徴 | データドリフト (Covariate Shift) | コンセプトドリフト (Concept Drift) | 評価ドリフト (Evaluation Drift) |

変化の対象 | 入力データの分布 $P(X)$ | 入出力の関係 $P(Y\|X$ | 評価基準・「正解」の定義 $Justification(Y)$ |

主な検知手法 | 統計的検定 (KS検定, MMD) | 誤差監視, 教師あり検定 | 監査ログ分析, 評価ストア更新, ユーザーFB |

前提 | モデル $P(Y\|X$ は固定 | データ分布 $P(X)$ は固定または変化 | 評価プロトコル(定規)が変化 |

Hinderらの対応 | 対応可能 (Kernel法) | 対応可能 (Moment Trees) | 対応不可 (参照分布依存) |

Dongらの対応 | 対応可能 (DDLA) | 対応可能 (精度低下検知) | 対応不可 (精度定義依存) |

リスク | 精度低下 | 誤った予測 | 沈黙の失敗, 誤った成功判定, 信頼崩壊 |

4. なぜ最新の先行研究は評価ドリフトを見逃すのか:深層分析

本章では、前述の理論に基づき、なぜHinderやDongのアプローチが評価ドリフトに対して脆弱であるのかを、具体的なメカニズムとともに論証する。

4.1 Dong et al. (2024) のDDLAにおける「有害性」判定の盲点

DongらのDDLA(Data Distributions with Low Accuracy)は、「精度が低い領域でのみ再学習する」という効率的な戦略をとる。しかし、この「精度(Accuracy)」を測定するためのGround Truth(正解ラベル)が本番環境で即座に得られない場合、あるいは遅延して得られる場合(Delayed Feedback)、彼らの手法は過去のデータセットに依存せざるを得ない。

シナリオ分析:Eコマースにおける「無害な」ドリフトの逆説

あるEコマースサイトで、ユーザーの購買行動が「PCサイト」から「モバイルアプリ」へ急激にシフトしたとする(データドリフト)。

Dongらの判定: 旧来のモデルがPCサイトでの購買データに基づいて訓練されており、モバイルからのアクセスに対しても(偶然)高い予測スコアを出している場合、DDLAは「精度低下なし=無害」と判定する。

評価ドリフトの視点: モバイルユーザーはPCユーザーとは異なるUI/UX文脈におり、クリックの意味(誤タップの可能性など)や滞在時間の評価基準が異なる。PC時代の基準で「高精度」と判定されることは、モバイル特有の機会損失(例:スクロール深度の無視)を見逃していることを意味する。ここで「正解」の定義は「購入」から「エンゲージメントの質」へとドリフトしている可能性があるが、固定された評価セットを用いるDDLAはこれを検知できない。

4.2 Hinder et al. (2024) の「分布」概念の静的な限界

HinderらのMoment Treesは、時間$T$を予測することで分布変化を検知する。これは「データがいつ発生したか」を識別する能力には長けているが、「そのデータの意味がどう変わったか」を問うものではない。

シナリオ分析:医療AIにおけるガイドライン改定

医療画像診断モデルにおいて、医学会が特定の疾患の診断基準(ガイドライン)を改定したとする。

Hinderらの判定: 入力画像(X線写真など)のピクセル分布$P(X)$には何の変化もないため、Moment Treesなどのカーネル法は「ドリフトなし」と判定する。

評価ドリフトの視点: 診断基準が変わったことで、過去のデータセットにおける正解ラベル$Y$の一部が誤り(False)となる。評価基準(正解ラベルの付与ルール)がドリフトしているため、モデルの出力$Y_{pred}$と新しい真の正解$Y_{true}$との間には乖離が生じる。分布監視はこの「ルールの変化」に対して盲目である。

4.3 Dwork et al. (2015) の警告と「使い古された定規」

Dong et al. (2024)は、ドリフト検知後に「再学習」を推奨するが、その再学習後のモデルを評価するために、同じテストセットを使い回すリスクについては言及していない。Dwork et al. (2015)が指摘するように、適応的なデータ分析においてテストセットを再利用することは、統計的な多重検定(Multiple Hypothesis Testing)の問題を引き起こし、有意水準を無効化する 22。

評価ドリフトの文脈では、これは「定規が使い古されて目盛りが読めなくなる」状態に等しい。Dongらのフレームワークでコスト削減のためにテストセットの更新を怠れば、モデルは「テストセットに適合するが、現実には適合しない」という過学習状態に陥り、評価ドリフトを加速させる。

5. 監査可能なAI安全性(Auditable AI Safety)へのアーキテクチャ

評価ドリフトを前提とした場合、AIの安全性を担保するためには、モデルの精度を監視するだけでは不十分である。評価プロセスそのものを継続的に更新・監査し、透明性を確保する新たなアーキテクチャが必要となる。我々は、以下の3つの主要コンポーネントからなる「監査可能なAI安全性」フレームワークを提案する。

5.1 動的評価ストア (Dynamic Evaluation Store)

固定されたテストセットを廃止し、常に更新される「評価ストア」を導入する。これは、23で言及されている概念を拡張したものである。

機能: 評価ストアは静的なファイルではなく、データベースである。ここには以下の3種類のデータが継続的に蓄積される。

ゴールデンセット (Golden Set): 人間が検証した最新の正解データ。

敵対的サンプル (Adversarial Examples): レッドチームテストや過去の失敗から生成された、モデルを騙すための難易度の高い入力。

エッジケース (Edge Cases): 本番環境で信頼度スコアが低かったデータや、ユーザーからのフィードバック(苦情など)があったデータ。

評価ドリフトへの対応: DongらのDDLA判定を行う際、固定されたテストセットではなく、この評価ストアから「鮮度(Freshness)」に基づいてサンプリングされたデータを使用する。これにより、常に「現在の基準」で有害性を判定できる。

5.2 不変監査ログ (Immutable Audit Logs) とMLメタデータ

評価ドリフトが発生した際、その原因を追跡し、説明責任(Accountability)を果たすためには、評価の履歴が改ざん不可能な形で記録されていなければならない。

機能: ブロックチェーンや追記型ストレージ(WORM)技術を用い、以下の情報を記録する 24。

評価ロジックのハッシュ: どのバージョンの評価コード、どのメトリック定義が使われたか。

データスナップショット: 評価に使用されたデータのIDと状態。

判定結果: スコアだけでなく、DDLAの判定結果や、再学習の可否判断。

Google ML Metadataの活用: 26にあるように、ML Metadata (MLMD) スキーマを用いて、アーティファクト(モデル、データ)と実行(評価、学習)の系譜(Lineage)をグラフ構造で管理する。これにより、「いつ、なぜ評価基準が変更されたか」を後から検証(Audit)可能にする。

5.3 差分監査 (Differential Auditing) による「なぜ」の解明

Hatherleyの「更新の不透明性」を解決し、データの来歴を証明するために、Mu et al. (2022)らが提案する「差分監査(Differential Auditing)」を導入する 28。

機能: 差分プライバシーの数学的枠組みを応用し、モデルの出力変化から、特定のデータセット(あるいは特定の評価基準)がモデルに与えた影響度を定量化する。

評価ドリフトへの対応: モデルの挙動が急変した際(Ghost Driftなど)、それが「データの追加」によるものか、「評価ロジックの変更」によるものか、あるいは「外部環境の変化」によるものかを切り分ける。もし、特定の有害なデータがモデルの構造変化を引き起こしている場合、差分監査によってその「毒(Poison)」を特定できる。

5.4 提案アーキテクチャの実装モデル

以下に、提案する「評価ドリフト対応型 AIOps」の全体像を示す。

レイヤー | 従来のMLOps (Dong/Hinderモデル) | 提案する AIOps (Auditable Safety モデル) |

監視対象 | データ分布 $P(X)$, モデル精度 $Acc$ | 評価基準の妥当性, ユーザー期待値との乖離 |

評価データ | 固定されたテストセット (Static Holdout) | Dynamic Evaluation Store (常に更新・循環) |

ドリフト判定 | 精度低下や分布乖離を検知 | 評価メトリックとビジネスKPIの相関乖離を検知 |

再学習トリガー | 有害なドリフト (DDLA) 発生時 | 評価ストアの更新時 または 適応的妥当性低下時 |

ログ管理 | システムログ, 実験管理ツール | Immutable Audit Log (評価ロジックの変更履歴を含む) |

人間への説明 | 精度指標 (F1, AUC) の提示 | Bi-factual Explanations (旧基準と新基準の差分説明) 17 |

6. 結論と将来展望

本レポートでは、Hinder et al. (2024)やDong et al. (2024)といった最新の研究が提示する監視フレームワークの限界を、「評価プロトコル固定の前提」という観点から分析した。MLシステムが実社会で運用される以上、入力データだけでなく、それを評価する「定規(評価基準)」自体も不可避的に変化(ドリフト)する。この**「評価ドリフト(Evaluation Drift)」**を無視したままの最適化は、局所的なコスト削減には寄与しても、長期的には「沈黙の失敗」や「ユーザーの信頼喪失」という致命的なリスクを招く。

我々が提案した「監査可能なAI安全性」フレームワークは、動的評価ストアと不変監査ログを核として、評価プロセスそのものを監視対象とするパラダイムシフトである。これにより、以下の3点が実現される。

真正性の回復: 固定された過去の遺物ではなく、現在の現実に即した「生きた評価」が可能になる。

透明性の確保: 更新の不透明性を解消し、なぜモデルがそのように振る舞うのかを、データの来歴と評価基準の変化から説明可能にする。

持続可能な安全性: 適応的な再学習プロセスの中に、評価基準の更新サイクルを組み込むことで、システムは環境変化に対して真にロバストになる。

今後の研究課題としては、評価ストアの自動更新アルゴリズムの高度化や、Ghost Driftのような構造的変化を早期に検知するための「意味論的ドリフト検知指標(Semantic Drift Metrics)」の開発が挙げられる。AIが自律性を高めるほど、それを律する「評価の技術」もまた、進化し続けなければならない。評価ドリフトへの対峙こそが、次世代のAIガバナンスにおける最重要課題である。

参考文献の統合的扱いについて:

本レポートでは、分析の根拠となる研究資料を文中の引用記号 によって明示し、議論の文脈に統合している。Hinder et al. (2024), Dong et al. (2024), Rabanser et al. (2019), Hatherley (2025), Dwork et al. (2015), Polo et al. (2023) などの主要な先行研究に加え、関連する技術ブログやドキュメント 11 から得られた洞察も反映されている。

コメント